- Met de Raspberry Pi AI HAT+ 2 kan de Raspberry Pi 5 LLM’s lokaal uitvoeren

- Hailo-10H-versneller levert 40 TOPS INT4-inferentievermogen

- De PCIe-interface maakt communicatie met hoge bandbreedte mogelijk tussen het bord en de Raspberry Pi 5

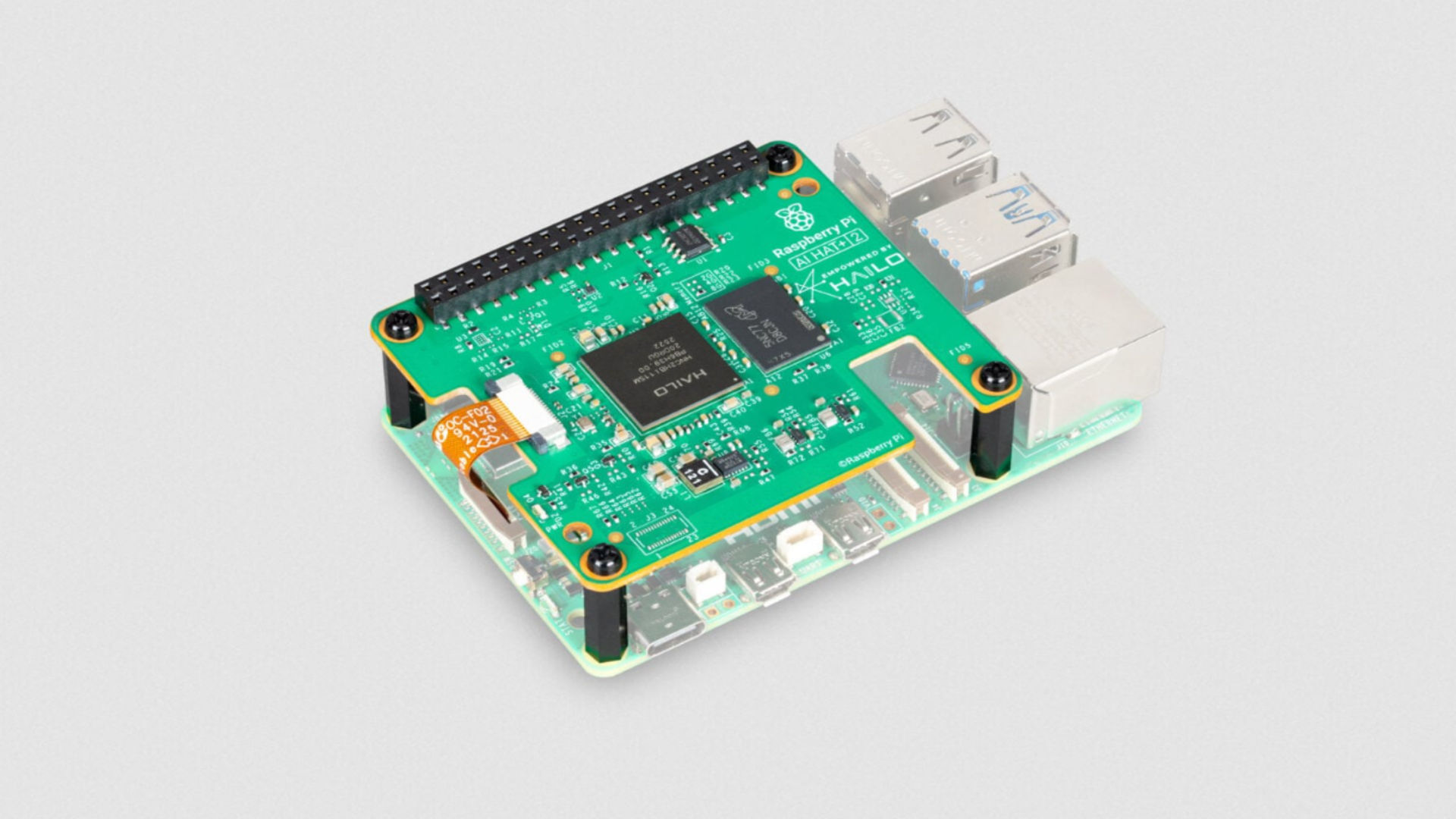

Raspberry Pi heeft zijn edge computing-ambities uitgebreid met de release van de HEB HOED+ 2een add-on-board ontworpen om generatieve AI-workloads naar de Raspberry Pi 5 te brengen.

Eerdere AI HAT-hardware was vrijwel uitsluitend gericht op de versnelling van computervisie en het afhandelen van taken zoals objectdetectie en scènesegmentatie.

Het nieuwe bestuur breidt die reikwijdte uit door te ondersteunen belangrijkste taalmodellen en visietaalmodellen die lokaal draaien zonder afhankelijk te zijn van cloudinfrastructuur of permanente netwerktoegang.

Hardwarewijzigingen die lokale taalmodellen mogelijk maken

De kern van de upgrade is de Hailo-10H neurale netwerkversneller, die 40TOPS aan INT4-inferentieprestaties levert.

In tegenstelling tot zijn voorganger heeft de AI HAT+ 2 8 GB speciaal ingebouwd geheugen, waardoor grotere modellen kunnen draaien zonder systeem-RAM op de host Raspberry Pi te verbruiken.

Deze wijziging maakt directe uitvoering van LLM’s en VLM’s op het apparaat mogelijk en handhaaft lage latentie en lokale gegevens, wat een belangrijke vereiste is voor veel edge-implementaties.

Een standaard gebruiken Raspberry Pi-distributiegebruikers kunnen ondersteunde modellen installeren en deze openen via vertrouwde interfaces zoals browsergebaseerde chattools.

De AI HAT+ 2 maakt verbinding met de Raspberry Pi 5 via de GPIO-header en vertrouwt voor gegevensoverdracht op de PCIe-interface van het systeem, wat compatibiliteit met de Raspberry Pi 4 uitsluit.

Deze verbinding ondersteunt gegevensoverdracht met hoge bandbreedte tussen de versneller en de host, wat essentieel is voor het efficiënt verplaatsen van modelinvoer, -uitvoer en cameragegevens.

Demonstraties omvatten het op tekst gebaseerde beantwoorden van vragen met Qwen2, het genereren van code met behulp van Qwen2.5-Coder, basisvertaaltaken en visuele scènebeschrijvingen van live camerafeeds.

Deze werklasten zijn afhankelijk van AI-hulpmiddelen verpakt om te werken in de Pi-softwarestack, inclusief gecontaineriseerde backends en lokale inferentieservers.

Alle verwerking vindt plaats op het apparaat zonder externe computerbronnen.

De ondersteunde modellen variëren van één tot anderhalf miljard parameters, wat bescheiden is vergeleken met cloudgebaseerde systemen die op veel grotere schaal werken.

Deze kleinere LLM’s richten zich op beperkte geheugen- en vermogensbereiken in plaats van op brede algemene kennis.

Om deze beperking aan te pakken ondersteunt AI HAT+ 2 verfijningsmethoden zoals Low-Rank Adaptation, waarmee ontwikkelaars modellen kunnen aanpassen voor beperkte taken, terwijl de meeste parameters ongewijzigd blijven.

Visiemodellen kunnen ook worden omgeschoold met behulp van applicatiespecifieke datasets via de toolchain van Hailo.

De AI HAT+ 2 is verkrijgbaar voor $ 130 en plaatst hem boven eerdere op visie gerichte accessoires, terwijl hij een vergelijkbare computervisie-doorvoer biedt.

Voor workloads die uitsluitend op imaging zijn gericht, biedt de upgrade beperkte voordelen, omdat de aantrekkingskracht ervan sterk afhankelijk is van lokale LLM-uitvoering en privacygevoelige applicaties.

In de praktijk laat de hardware zien dat generatieve AI op Raspberry Pi-hardware nu mogelijk is, hoewel beperkte geheugenhoogte en kleine modelgroottes een probleem blijven.

Volg TechRadar op Google Nieuws En voeg ons toe als voorkeursbron om ons deskundig nieuws, recensies en meningen in uw feeds te krijgen. Klik dan zeker op de knop Volgen!

En jij kunt dat natuurlijk ook Volg TechRadar op TikTok voor nieuws, recensies, video-unboxings en ontvang regelmatig updates van ons WhatsAppen Ook.