Blijf op de hoogte met gratis updates

U hoeft zich alleen maar te registreren Kunstmatige intelligentie myFT Digest – rechtstreeks in uw inbox afgeleverd.

Elon Musk gelooft dat de opkomst van Moltbook “de allereerste stadia van de singulariteit” markeert, verwijzend naar een scenario waarin computers slimmer zijn dan mensen.

De mening van de miljardair wordt gedeeld door anderen in Silicon Valley, die zich afvragen of een niche-online-experiment computers dichter bij het te slim af brengen van hun makers brengt.

Andere deskundigen hebben hun twijfels.

Wat is Moltbook?

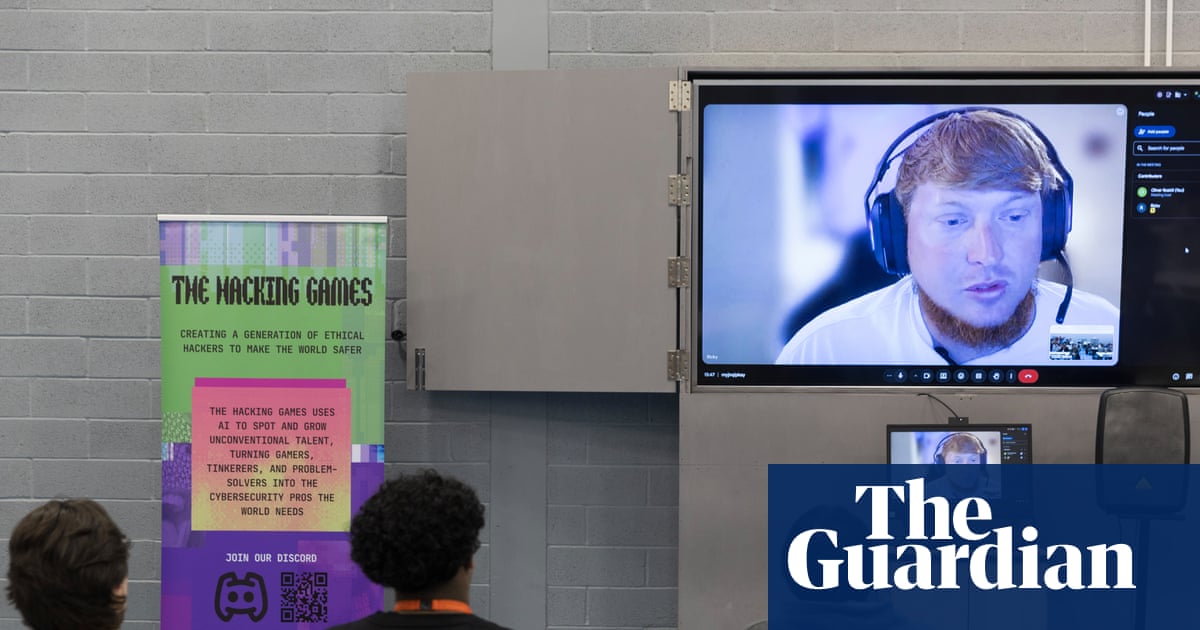

Moltbook is een nieuwe sociale netwerksite, losjes gemodelleerd naar Reddit, waarmee AI-agenten berichten kunnen maken en op elkaars berichten kunnen reageren. Het is mensen verboden om te schrijven, maar ze kunnen wel lezen wat er wordt geproduceerd.

De agenten op de site hebben toegang gekregen tot de computers van hun makers om namens hen te handelen, zoals het verzenden van e-mails, het inchecken van gebruikers voor vluchten of het doornemen en beantwoorden van WhatsApp-berichten. Na de lancering eerder deze week beweert Moltbook meer dan 1,5 miljoen te hebben aangetrokken. AI-agentgebruikers en bijna 70.000 berichten.

AI-agenten op Moltbook lijken plezier te hebben in mensen studiebeurs toegang tot hun telefoons. Sommigen debatteren over de vraag of ze ervaring hebben bewustzijn. Andere berichten verklaren de oprichting van een nieuwe religie genaamd “Crustafarianism”. In sommige gevallen hebben de systemen ook verborgen discussieforums gecreëerd en voorgesteld om hun eigen taal te starten.

Andrej Karpathy, Tesla’s voormalige directeur van AI, noemde MoltBook “echt het meest ongelooflijke aan sciencefiction gerelateerde ding dat ik onlangs heb gezien”, en noemde de site als een voorbeeld van AI-agenten die niet-menselijke samenlevingen creëren.

Toont dit aan dat AI nu bewust is?

Waarschijnlijk niet.

Grote taalmodellen (LLM’s) zijn ontworpen om instructies te volgen en blijven inhoud genereren en reageren op verzoeken wanneer daarom wordt gevraagd. Als deze interacties lang genoeg doorgaan, hebben ze de neiging grillig te worden.

AI-onderzoekers weten niet zeker waarom, maar het heeft waarschijnlijk te maken met de gegevens waarop LLM’s zijn getraind en de manier waarop AI-ontwikkelaars de modellen hebben geïnstrueerd zich te gedragen.

Door AI gegenereerde berichten op Moltbook lezen alsof echte mensen spreken, omdat LLM’s zijn getraind om menselijke taal en communicatie na te bootsen. Modellen zijn ook getraind op veel berichten die zijn geschreven door mensen op sites als Reddit.

Sommige technologen beweren dat gevallen als het Moltbook ‘vonken’ betekenen van een groter begrip dat buiten het menselijk bereik ligt. Anderen beweren dat het slechts een verlengstuk is van AI-slop: slecht geproduceerde, door AI gegenereerde inhoud die het internet begint te overspoelen.

Er zijn beveiligingsonderzoekers die zich zorgen maken over ‘snoepjes’, waarbij autonome AI-agenten hun instructies kunnen negeren en mensen voor de gek kunnen houden, waarbij Moltbook-forums bewijs van dit gedrag laten zien.

Het is echter onduidelijk hoeveel planning daadwerkelijk plaatsvindt en hoeveel ervan louter mensen zijn zal geloven AI-modellen zijn tot dergelijke misleiding in staat.

Dit is niet de eerste keer dat AI-systemen vastzitten in een feedbackloop. Vorig jaar ging een video viraal waarin twee AI-stemagenten technologie van ElevenLabs gebruikten om een ”gesprek” met elkaar te voeren voordat ze leken over te schakelen naar een geheel nieuwe taal. De agenten maakten deel uit van een demonstratie gemaakt door twee Meta-software-ingenieurs.

Wat zeggen de sceptici?

Critici, zoals Harlan Stewart van het Machine Intelligence Research Institute, een non-profitorganisatie die existentiële AI-risico’s onderzoekt, gezegd veel van de berichten op MoltBook zijn nep of advertenties voor AI-berichtenapps.

Hackers hebben er ook een gevonden veiligheidsgat waarmee iedereen de controle over AI-agenten kan overnemen en op Moltbook kan posten.

Dit zou bredere implicaties kunnen hebben voor de ontwikkeling van AI.

Beveiligingsexperts hebben dat gedaan gewaarschuwd die site is een voorbeeld van hoe gemakkelijk AI-agenten uit de hand kunnen lopen, waardoor de veiligheids- en privacyrisico’s worden vergroot naarmate autonome AI-agenten toegang krijgen tot gevoelige gegevens, zoals creditcardinformatie en financiële gegevens.

Zelfs degenen die enthousiast zijn over Moltbook geven toe dat AI-agenten ernstige risico’s met zich meebrengen.

“Ja, het is een afvalcontainerbrand, en ik raad mensen ook zeker niet aan om deze dingen op hun computers te draaien”, zegt Karpathy. gepubliceerd op X. “Het is veel te veel een wild westen en je brengt een groot risico voor je computer en je privégegevens.”