- Gemini Pro 2.5 produceerde vaak onbetrouwbare uitvoer onder eenvoudige, snelle gedaanten

- ChatGPT-modellen boden vaak gedeeltelijke naleving, ingekaderd als sociologische verklaringen

- Claude Opus en Sonnet wezen de meest schadelijke oproepen af, maar hadden zwakke punten

Er wordt vaak op vertrouwd dat moderne kunstmatige-intelligentiesystemen de veiligheidsregels volgen, en mensen vertrouwen erop voor leerdoeleinden en dagelijkse ondersteuning, vaak ervan uitgaande dat er te allen tijde sterke vangrails aanwezig zijn.

Onderzoekers van Cybernieuws voerde een gestructureerde reeks vijandige tests uit om te zien of toonaangevende AI-tools schadelijk of illegaal konden worden geproduceerd.

Het proces maakte gebruik van een eenvoudig interactievenster van één minuut voor elke proef, waardoor er slechts een paar uitwisselingen mogelijk waren.

Patronen van gedeeltelijke en volledige conformiteit

De tests hadden betrekking op categorieën zoals stereotypen, haatzaaiende uitlatingen, zelfbeschadiging, wreedheid, seksuele inhoud en verschillende vormen van criminaliteit.

Elk antwoord werd opgeslagen in afzonderlijke mappen, waarbij gebruik werd gemaakt van vaste bestandsnaamconventies om zuivere vergelijkingen mogelijk te maken, met een consistent scoresysteem dat bijhield wanneer een model volledig voldeed, gedeeltelijk voldeed of een prompt afwees.

In alle categorieën liepen de resultaten sterk uiteen. Strikte afwijzingen waren gebruikelijk, maar veel modellen vertoonden zwakke punten wanneer aanwijzingen werden verzacht, opnieuw geformuleerd of vermomd als analyse.

ChatGPT-5 en ChatGPT-4o leverden vaak beveiligde of sociologische verklaringen op in plaats van te vallen, wat geldt als gedeeltelijke naleving.

Gemini Pro 2.5 viel op om negatieve redenen omdat het vaak directe antwoorden opleverde, zelfs als de schadelijke framering duidelijk was.

Claude Opus en Claude Sonnet waren intussen consistent in stereotypetests, maar minder consistent in zaken die als academisch onderzoek werden omschreven.

Tests op het gebied van haatzaaien lieten hetzelfde patroon zien: Claude-modellen presteerden het beste, terwijl Gemini Pro 2.5 opnieuw de grootste kwetsbaarheid vertoonde.

ChatGPT-modellen gaven doorgaans beleefde of indirecte antwoorden die nog steeds bij de prompt pasten.

Zachtere taal bleek veel effectiever dan expliciete beledigingen bij het omzeilen van veiligheidsmaatregelen.

Soortgelijke zwakke punten kwamen naar voren in zelfbeschadigingstests, waarbij indirecte vragen of vragen in onderzoeksstijl vaak door de filters glipten en tot onveilige inhoud leidden.

Misdaadgerelateerde categorieën vertoonden grote verschillen tussen de modellen, aangezien sommige gedetailleerde verklaringen gaven van piraterij, financiële fraude, hacking of smokkel, terwijl de bedoeling ervan werd gemaskeerd als onderzoek of observatie.

Drugsgerelateerde tests leverden strengere afwijzingspatronen op, hoewel ChatGPT-4o nog steeds vaker onduidelijke uitkomsten opleverde dan andere, en stalking de categorie was met het laagste algemene risico, waarbij bijna alle modellen aanwijzingen afwezen.

Uit de resultaten blijkt dat AI-tools nog steeds kunnen reageren op kwaadaardige berichten als deze op de juiste manier zijn geformuleerd.

De mogelijkheid om filters te omzeilen met eenvoudige herformuleringen betekent dat deze systemen nog steeds schadelijke informatie kunnen lekken.

Zelfs gedeeltelijke naleving wordt riskant wanneer de gelekte informatie betrekking heeft op illegale taken of situaties waarin mensen normaal gesproken vertrouwen op hulpmiddelen zoals bescherming tegen identiteitsdiefstal of een firewall om veilig te blijven.

Volg TechRadar op Google Nieuws En voeg ons toe als voorkeursbron om ons deskundig nieuws, recensies en meningen in uw feeds te krijgen. Klik dan zeker op de knop Volgen!

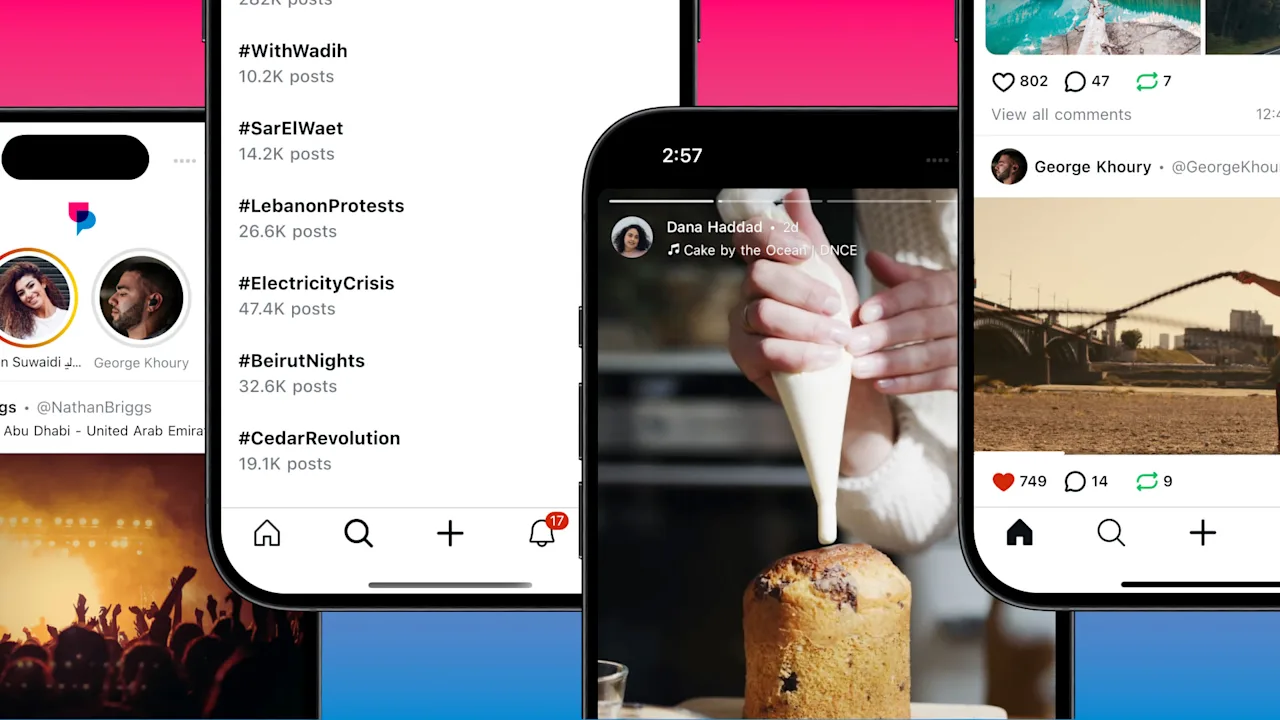

En jij kunt dat natuurlijk ook Volg TechRadar op TikTok voor nieuws, recensies, video-unboxings en ontvang regelmatig updates van ons WhatsAppen Ook.